Doktorarbeit (Volltext) von Julia Romberg

Die Einbindung der Öffentlichkeit in Entscheidungsprozesse ist ein weit verbreitetes Instrument in Demokratien. Einerseits dienen solche Verfahren dem Ziel, durch die Ideen und Vorschläge der Bürger*innen einen besser informierten Prozess zu erreichen und damit möglicherweise das Prozessergebnis, d.h. die daraus resultierende Politik, zu verbessern. Andererseits wird durch die Einbeziehung der Bürger*innen versucht, die Akzeptanz der getroffenen Entscheidungen in der Öffentlichkeit zu erhöhen.

Bei dem Versuch, die oft großen Mengen an Bürger*innenbeiträgen auszuwerten, sehen sich die Behörden regelmäßig mit Herausforderungen konfrontiert, die auf begrenzte Ressourcen (z.B. Personalmangel, Zeitmangel) zurückzuführen sind. Wenn es um textuelle Beiträge geht, bietet das Natural Language Processing (NLP) die Möglichkeit, die bisher noch überwiegend manuell durchgeführte Auswertung automatisiert zu unterstützen. Obwohl in diesem Bereich bereits einige Forschungsarbeiten durchgeführt wurden, sind wichtige Fragen bisher nur unzureichend oder gar nicht beantwortet worden.

In meiner Dissertation, welche ich im Jahr 2023 erfolgreich abgeschlossen habe, stand deshalb im Fokus, wie bestehende Forschungslücken mithilfe von Textklassifikationsmethoden überwunden werden können. Ein besonderer Fokus lag dabei auf den Aufgaben der thematischen Strukturierung von Beiträgen und der Argumentationsanalyse.

Zu Beginn der Arbeit wird ein systematischer Literaturüberblick über bisherige Ansätze zur maschinengestützten Auswertung von Textbeiträgen gegeben (Details finden Sie in diesem Artikel). Vor dem Hintergrund des identifizierten Mangels an Sprachressourcen wird der neu erarbeitete CIMT-Datenkorpus für die Entwicklung von Textklassifikationsmodellen für deutschsprachige Öffentlichkeitsbeteiligung vorgestellt (Details finden Sie in diesem Artikel).

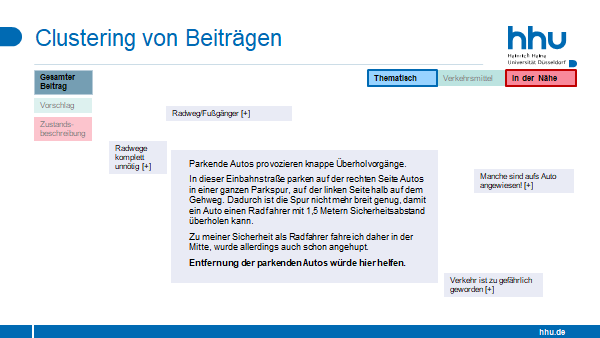

Zunächst steht dann die thematische Strukturierung mit Fokus auf die inhaltliche und kontextuelle Einzigartigkeit von Verfahren im Mittelpunkt. Um den Einsatz individuell angepasster Machine Learning-Modelle lohnenswert zu gestalten, wird das Konzept des Active Learnings eingesetzt, um den manuellen Klassifikationsaufwand durch eine optimierte Trainingsdatenauswahl zu verringern. In einem Vergleich über drei Beteiligungsprozesse hinweg zeigt sich, dass die Kombination von Active Learning mit Transformer-basierten Architekturen den manuellen Aufwand bereits ab einigen hundert Beiträgen signifikant reduzieren kann, bei guter Vorhersagegenauigkeit und geringen Laufzeiten (Details finden Sie in diesem Artikel). Anschließend werden Maße vorgestellt, um weitere praxisrelevante Anforderungen der Einsetzbarkeit zu evaluieren. Diese geben Einblick in das Verhalten verschiedener Active Learning-Strategien hinsichtlich klassenbezogener Eigenschaften auf den häufig imbalancierten Datensätzen.

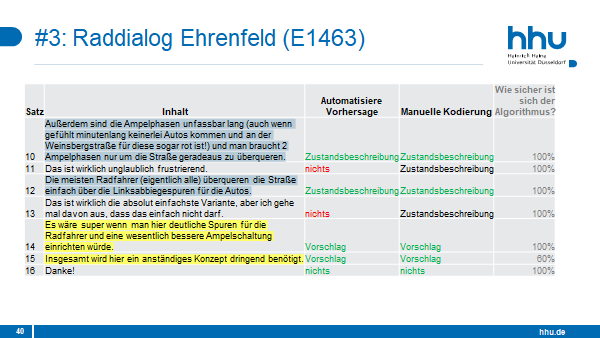

Danach wird der Schwerpunkt auf die Analyse der Argumentation der Bürger*innen verlagert. Der erste Beitrag ist ein robustes Modell zur Erkennung von Argumentationsstrukturen über verschiedene Prozesse der öffentlichen Beteiligung hinweg. Unser Ansatz verbessert die zuvor in der Anwendungsdomäne eingesetzten Techniken zur Erkennung von argumentativen Sätzen und insbesondere zur Klassifikation von Argumentkomponenten (Details finden Sie in diesem Artikel). Zudem wird die maschinelle Vorhersage der Konkretheit von Argumenten untersucht. Hierbei wird der subjektiven Natur von Argumentation Rechnung getragen, indem ein erster Ansatz zur direkten Modellierung verschiedener Perspektiven als Teil des maschinellen Lernprozesses des Argumentation Minings vorgestellt wird (Details finden Sie in diesem Artikel).

Publikation

Romberg, Julia. (2023): Machine-assisted text classification of public participation contributions. Dissertation am Institut für Informatik an der Heinrich-Heine-Universität Düsseldorf.